кластеризації k-means (2)

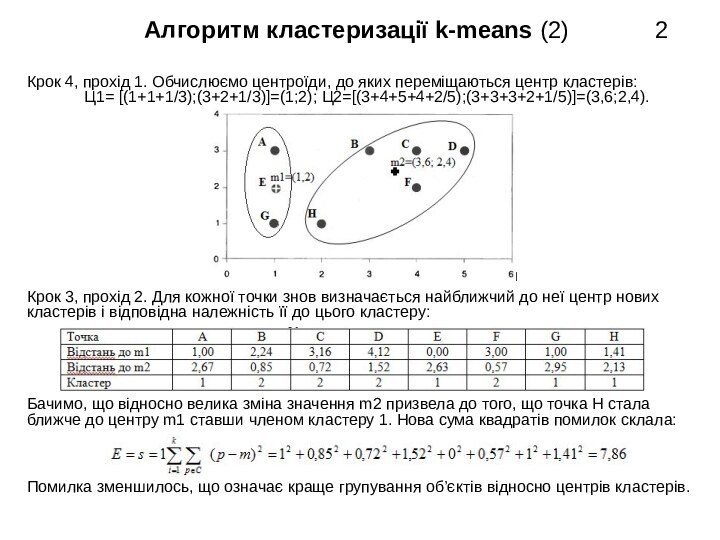

Крок 4, прохід 1. Обчислюємо центроїди, до яких переміщаються центр кластерів:

Ц1= [(1+1+1/3);(3+2+1/3)]=(1;2); Ц2=[(3+4+5+4+2/5);(3+3+3+2+1/5)]=(3,6;2,4).

Крок 3, прохід 2. Для кожної точки знов визначається найближчий до неї центр нових

кластерів і відповідна належність її до цього кластеру:

Бачимо, що відносно велика зміна значення m2 призвела до того, що точка Н стала

ближче до центру m1 ставши членом кластеру 1. Нова сума квадратів помилок склала:

Помилка зменшилось, що означає краще групування об’єктів відносно центрів кластерів.