Слайд 2

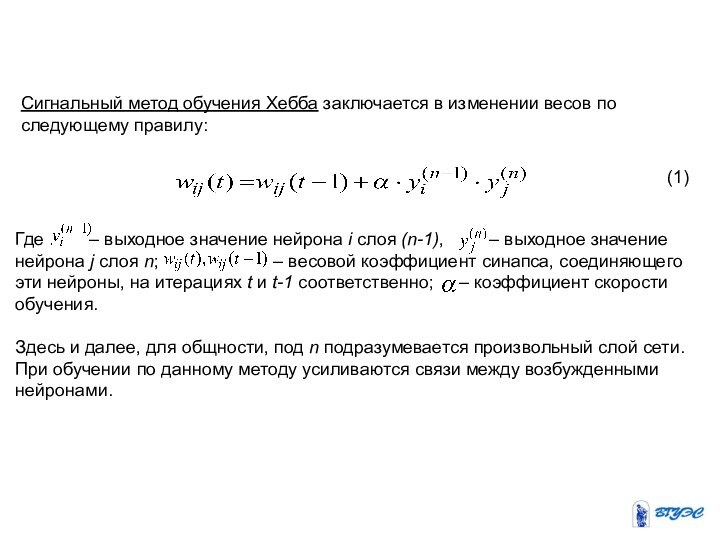

Сигнальный метод обучения Хебба заключается в изменении весов

по следующему правилу:

(1)

Где – выходное

значение нейрона i слоя (n-1), – выходное значение нейрона j слоя n; – весовой коэффициент синапса, соединяющего эти нейроны, на итерациях t и t-1 соответственно; – коэффициент скорости обучения.

Здесь и далее, для общности, под n подразумевается произвольный слой сети. При обучении по данному методу усиливаются связи между возбужденными нейронами.

Слайд 3

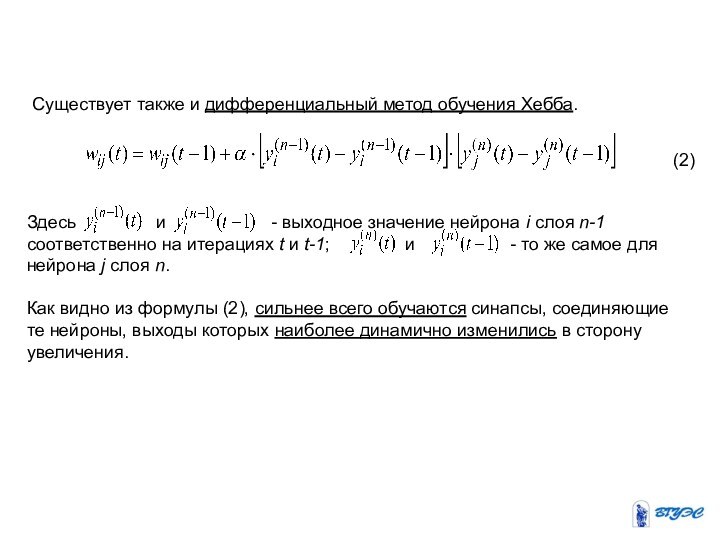

Существует также и дифференциальный метод обучения Хебба.

(2)

Здесь

и

- выходное значение нейрона i слоя n-1 соответственно на итерациях t и t-1; и - то же самое для нейрона j слоя n.

Как видно из формулы (2), сильнее всего обучаются синапсы, соединяющие те нейроны, выходы которых наиболее динамично изменились в сторону увеличения.

Слайд 4

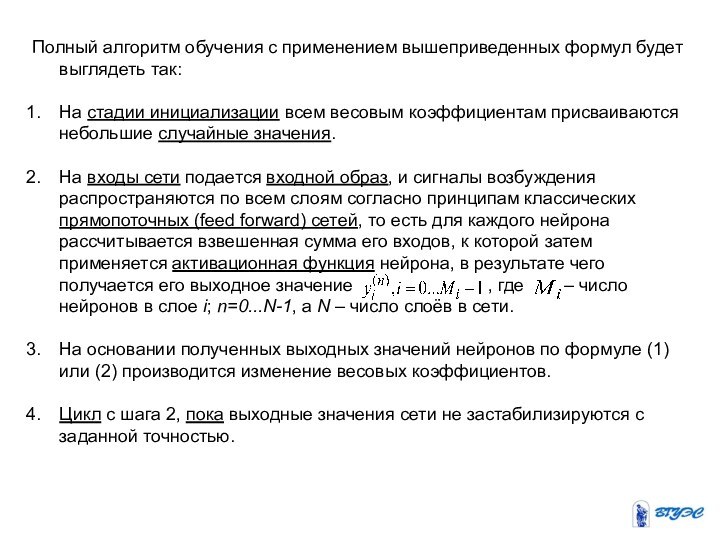

Полный алгоритм обучения с применением вышеприведенных формул будет

выглядеть так:

На стадии инициализации всем весовым коэффициентам присваиваются небольшие

случайные значения.

На входы сети подается входной образ, и сигналы возбуждения распространяются по всем слоям согласно принципам классических прямопоточных (feed forward) сетей, то есть для каждого нейрона рассчитывается взвешенная сумма его входов, к которой затем применяется активационная функция нейрона, в результате чего получается его выходное значение , где – число нейронов в слое i; n=0...N-1, а N – число слоёв в сети.

На основании полученных выходных значений нейронов по формуле (1) или (2) производится изменение весовых коэффициентов.

Цикл с шага 2, пока выходные значения сети не застабилизируются с заданной точностью.

Слайд 5

Применение этого нового способа определения завершения обучения, отличного

от использовавшегося для сети обратного распространения, обусловлено тем, что

подстраиваемые значения синапсов фактически не ограничены.

На втором шаге цикла попеременно предъявляются все образы из входного набора.

Слайд 6

Следует отметить, что вид откликов на каждый класс

входных образов не известен заранее и будет представлять собой

произвольное сочетание состояний нейронов выходного слоя, обусловленное случайным распределением весов на стадии инициализации.

Вместе с тем, сеть способна обобщать схожие образы, относя их к одному классу. Тестирование обученной сети позволяет определить топологию классов в выходном слое.

Для приведения откликов обученной сети к удобному представлению можно дополнить сеть одним слоем, который, например, по алгоритму обучения однослойного перцептрона необходимо заставить отображать выходные реакции сети в требуемые образы.

Слайд 7

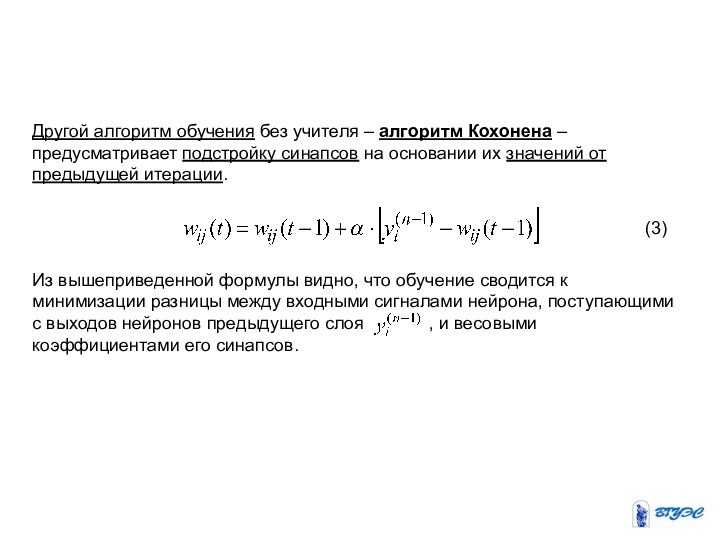

Другой алгоритм обучения без учителя – алгоритм Кохонена

– предусматривает подстройку синапсов на основании их значений от

предыдущей итерации.

(3)

Из вышеприведенной формулы видно, что обучение сводится к минимизации разницы между входными сигналами нейрона, поступающими с выходов нейронов предыдущего слоя , и весовыми коэффициентами его синапсов.

Слайд 8

Полный алгоритм обучения имеет примерно такую же структуру,

как в методах Хебба, но на шаге 3 из

всего слоя выбирается нейрон, значения синапсов которого максимально походят на входной образ, и подстройка весов по формуле (3) проводится только для него.

Эта, так называемая, аккредитация может сопровождаться затормаживанием всех остальных нейронов слоя и введением выбранного нейрона в насыщение.

Выбор такого нейрона может осуществляться, например, расчетом скалярного произведения вектора весовых коэффициентов с вектором входных значений.

Максимальное произведение дает “выигравший” нейрон.

Слайд 9

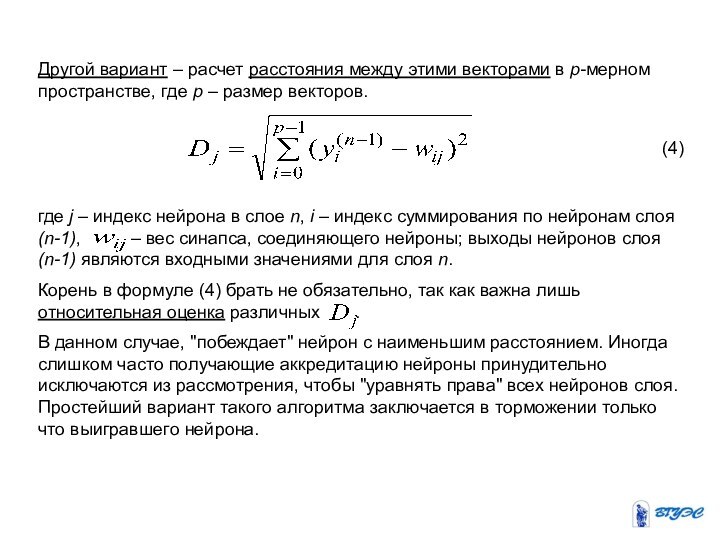

Другой вариант – расчет расстояния между этими векторами

в p-мерном пространстве, где p – размер векторов.

(4)

где

j – индекс нейрона в слое n, i – индекс суммирования по нейронам слоя (n-1), – вес синапса, соединяющего нейроны; выходы нейронов слоя (n-1) являются входными значениями для слоя n.

Корень в формуле (4) брать не обязательно, так как важна лишь относительная оценка различных .

В данном случае, "побеждает" нейрон с наименьшим расстоянием. Иногда слишком часто получающие аккредитацию нейроны принудительно исключаются из рассмотрения, чтобы "уравнять права" всех нейронов слоя. Простейший вариант такого алгоритма заключается в торможении только что выигравшего нейрона.

Слайд 10

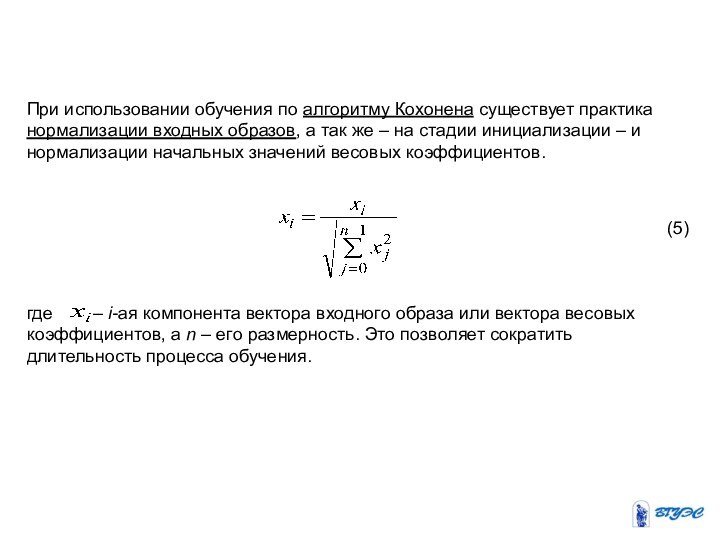

При использовании обучения по алгоритму Кохонена существует практика

нормализации входных образов, а так же – на стадии

инициализации – и нормализации начальных значений весовых коэффициентов.

(5)

где – i-ая компонента вектора входного образа или вектора весовых коэффициентов, а n – его размерность. Это позволяет сократить длительность процесса обучения.

Слайд 11

Инициализация весовых коэффициентов случайными значениями может привести к

тому, что различные классы, которым соответствуют плотно распределенные входные

образы, сольются или, наоборот, раздробятся на дополнительные подклассы в случае близких образов одного и того же класса.

Для избегания такой ситуации используется метод выпуклой комбинации [Лигун А. А., Малышева А. Д. Математическая обработка результатов эксперимента. // Днепродзержинск: ДИИ, 1992—47с ].

Слайд 12

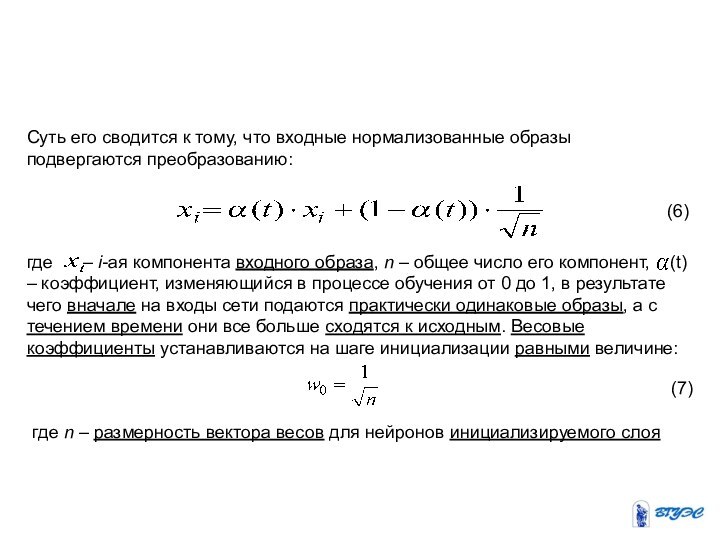

Суть его сводится к тому, что входные нормализованные

образы подвергаются преобразованию:

(6)

где – i-ая компонента

входного образа, n – общее число его компонент, (t) – коэффициент, изменяющийся в процессе обучения от 0 до 1, в результате чего вначале на входы сети подаются практически одинаковые образы, а с течением времени они все больше сходятся к исходным. Весовые коэффициенты устанавливаются на шаге инициализации равными величине:

(7)

где n – размерность вектора весов для нейронов инициализируемого слоя