- Главная

- Разное

- Бизнес и предпринимательство

- Образование

- Развлечения

- Государство

- Спорт

- Графика

- Культурология

- Еда и кулинария

- Лингвистика

- Религиоведение

- Черчение

- Физкультура

- ИЗО

- Психология

- Социология

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Геометрия

- Детские презентации

- Информатика

- История

- Литература

- Маркетинг

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

Что такое findslide.org?

FindSlide.org - это сайт презентаций, докладов, шаблонов в формате PowerPoint.

Обратная связь

Email: Нажмите что бы посмотреть

Презентация на тему Визуализация многомерных пространств

Содержание

- 2. Где мы встречаем многомерные пространства? Одна из самых распространенных областей - анализ данных:

- 3. Цель визуализации Цель – получить отображение

- 4. "To deal with hyper-planes in a 14

- 5. МетодыРассмотрим методы, сопоставляющие точке в n-мерном пространстве точку в пространстве меньшей размерности:

- 6. Метод главных компонент (PCA)Основной линейный метод понижения

- 7. Максимизировать вариацию по векторуМинимизировать сумму расстояний от точки до ее проекции на данный вектор

- 8. Записать x1 … xn как вектор-строкиРазместить вектор-строки

- 9. Шаг 2: Оцентрировать данныеНайти среднее по каждой колонкеВычесть вектор средних из каждой строки матрицы объектов-признаков Х

- 10. Шаг 3: Вычислить матрицу ковариацииНайти матрицу ковариации

- 11. Шаг 4: Найти собственные вектора и собственные

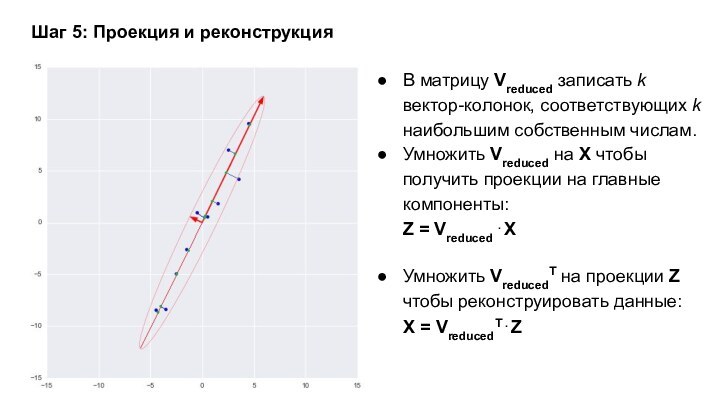

- 12. Шаг 5: Проекция и реконструкцияВ матрицу Vreduced

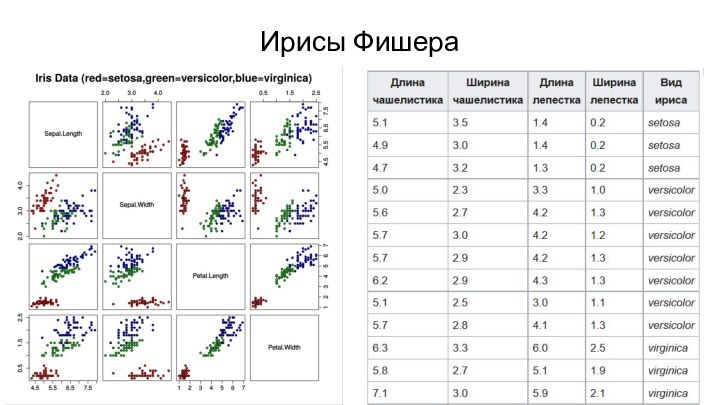

- 13. Ирисы Фишера

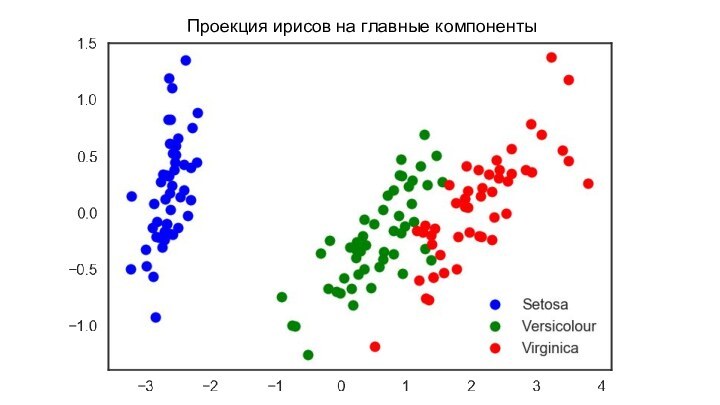

- 14. Проекция ирисов на главные компоненты

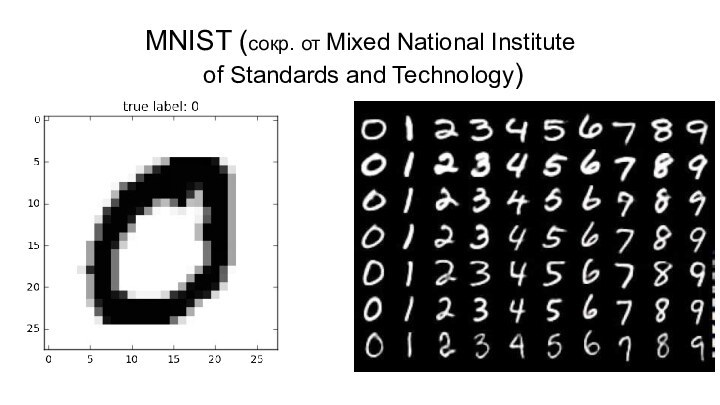

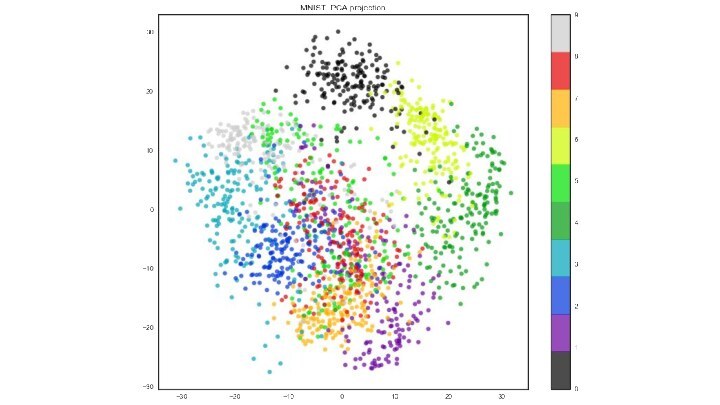

- 15. MNIST (сокр. от Mixed National Institute of Standards and Technology)

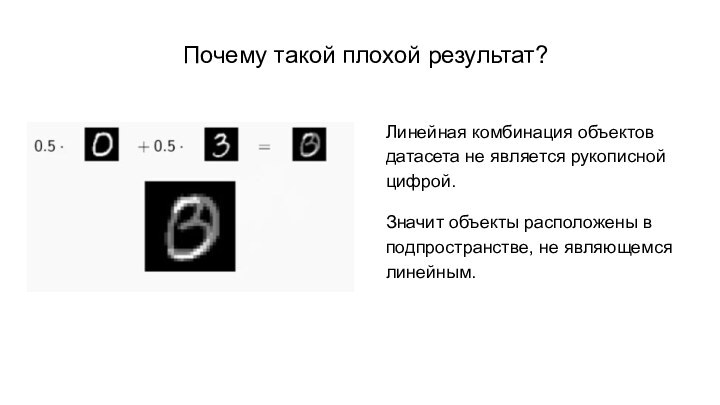

- 17. Почему такой плохой результат?Линейная комбинация объектов датасета

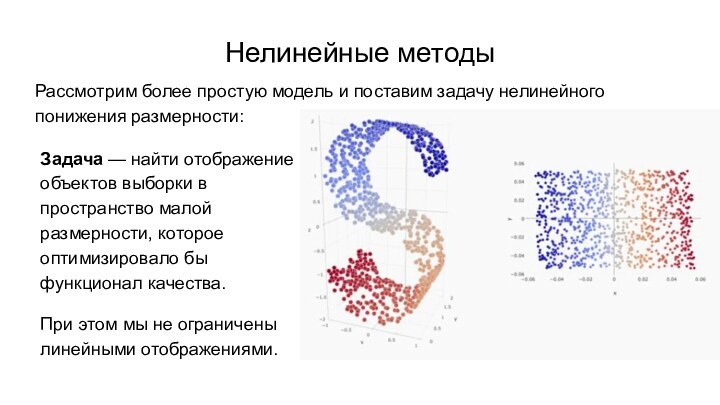

- 18. Нелинейные методыРассмотрим более простую модель и поставим

- 19. Гипотеза: малоразмерное представление сохраняет попарные расстояния между

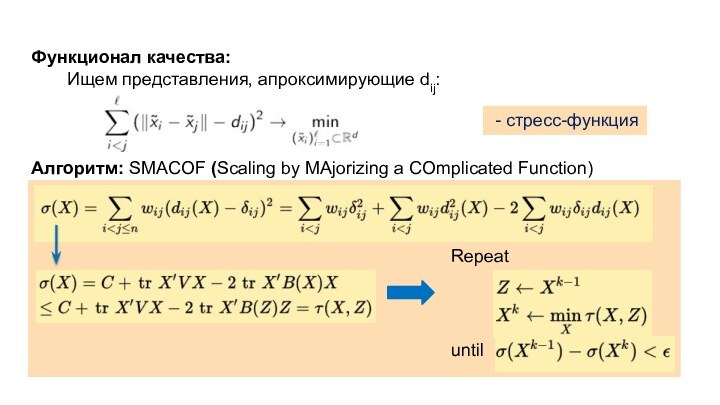

- 20. Функционал качества: Ищем представления, апроксимирующие dij:Алгоритм: SMACOF (Scaling by MAjorizing a COmplicated Function) - стресс-функцияRepeatuntil

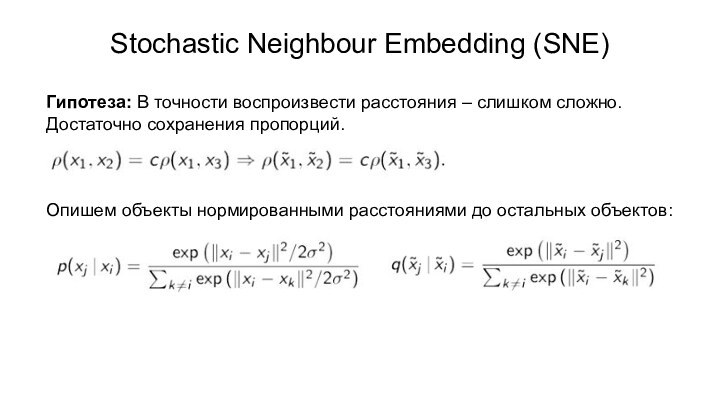

- 21. Stochastic Neighbour Embedding (SNE)Гипотеза: В точности воспроизвести

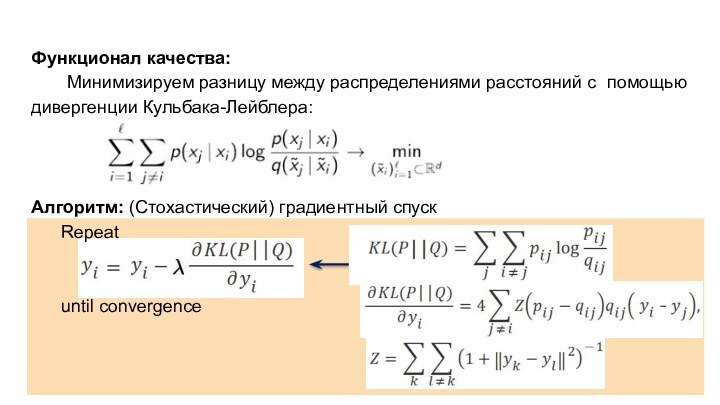

- 22. Функционал качества: Минимизируем разницу между распределениями расстояний с

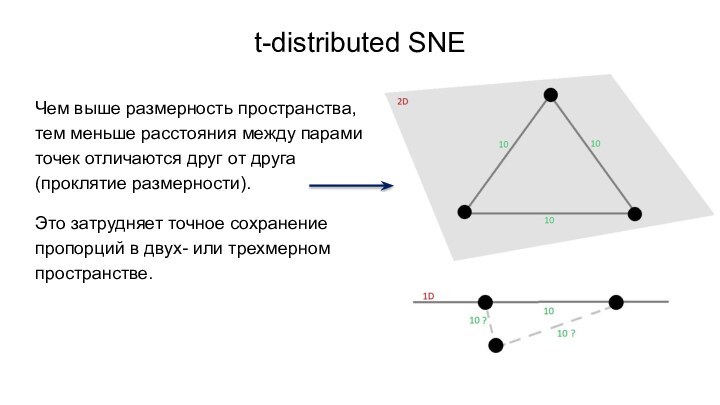

- 23. t-distributed SNEЧем выше размерность пространства, тем меньше

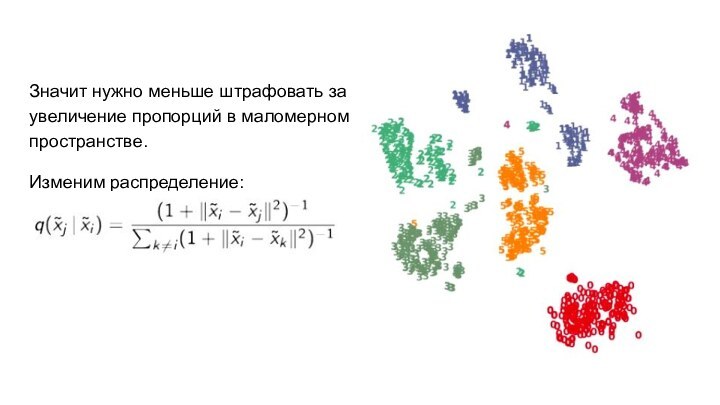

- 24. Значит нужно меньше штрафовать за увеличение пропорций в маломерном пространстве.Изменим распределение:

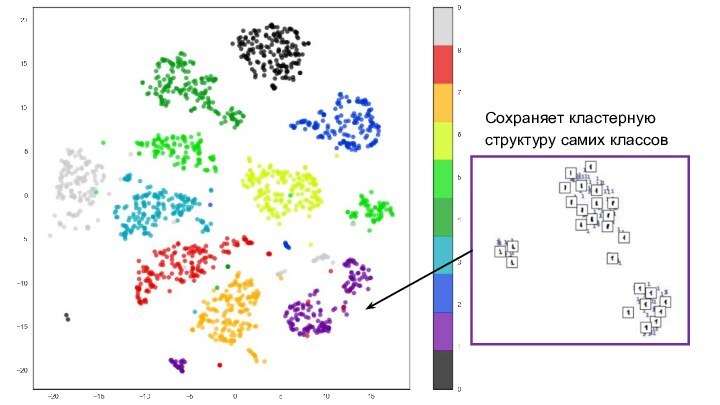

- 25. Сохраняет кластерную структуру самих классов

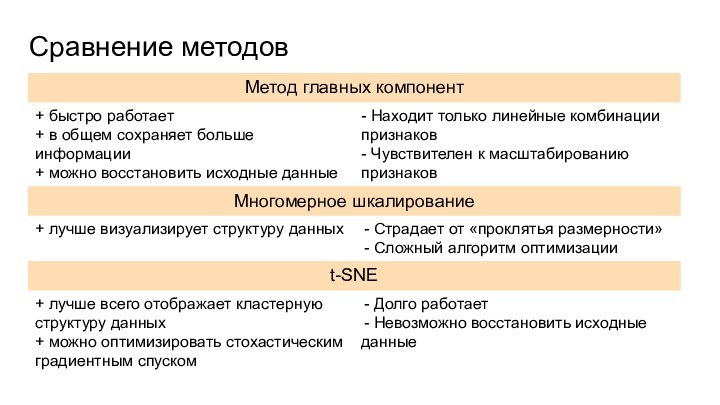

- 26. Сравнение методов

- 27. Выводы Существует множество методов визуализации многомерных данных

- 28. Скачать презентацию

- 29. Похожие презентации

Где мы встречаем многомерные пространства? Одна из самых распространенных областей - анализ данных:

Слайд 2

Где мы встречаем многомерные пространства?

Одна из самых

распространенных областей - анализ данных:

Слайд 3

Цель визуализации

Цель – получить отображение данных

в 2 или 3 мерном пространстве для дальнейшего изучения

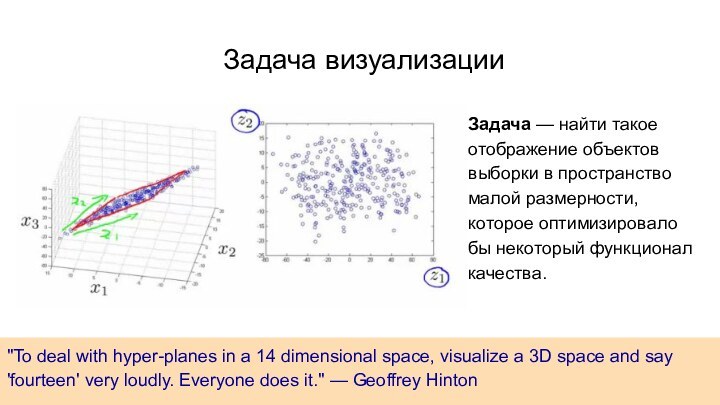

структурных особенностей и закономерностей этих данных.Слайд 4 "To deal with hyper-planes in a 14 dimensional

space, visualize a 3D space and say 'fourteen' very

loudly. Everyone does it." — Geoffrey HintonЗадача — найти такое отображение объектов выборки в пространство малой размерности, которое оптимизировало бы некоторый функционал качества.

Задача визуализации

Слайд 5

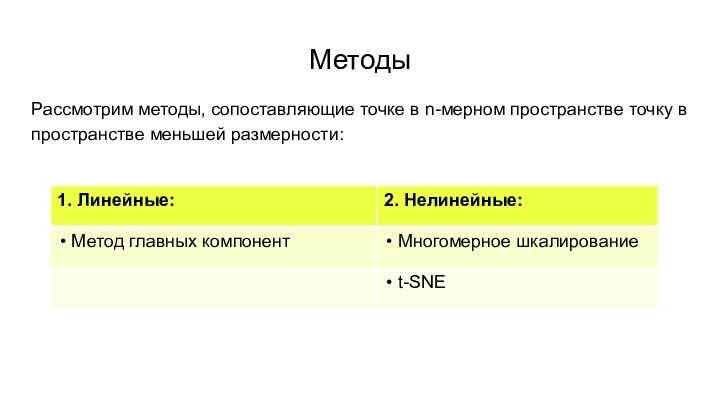

Методы

Рассмотрим методы, сопоставляющие точке в n-мерном пространстве точку

в пространстве меньшей размерности:

Слайд 6

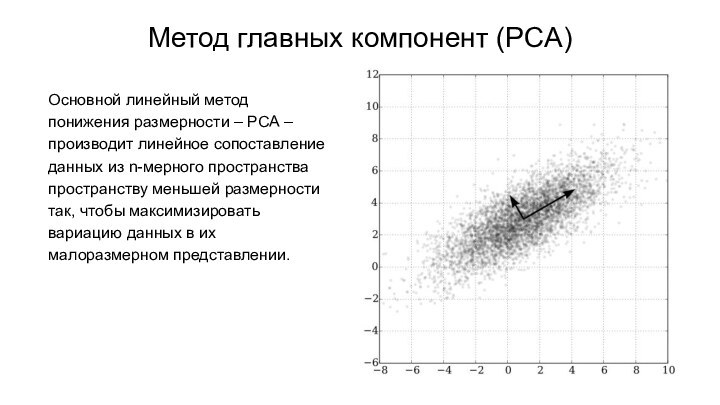

Метод главных компонент (PCA)

Основной линейный метод понижения размерности

– PCA – производит линейное сопоставление данных из n-мерного

пространства пространству меньшей размерности так, чтобы максимизировать вариацию данных в их малоразмерном представлении.

Слайд 7

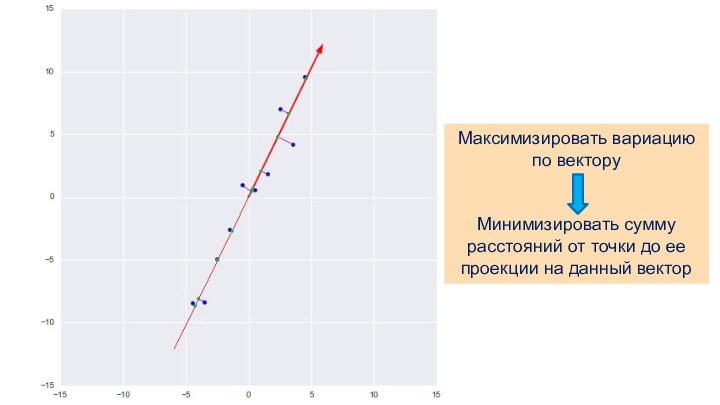

Максимизировать вариацию по вектору

Минимизировать сумму расстояний от точки

до ее проекции на данный вектор

Слайд 8

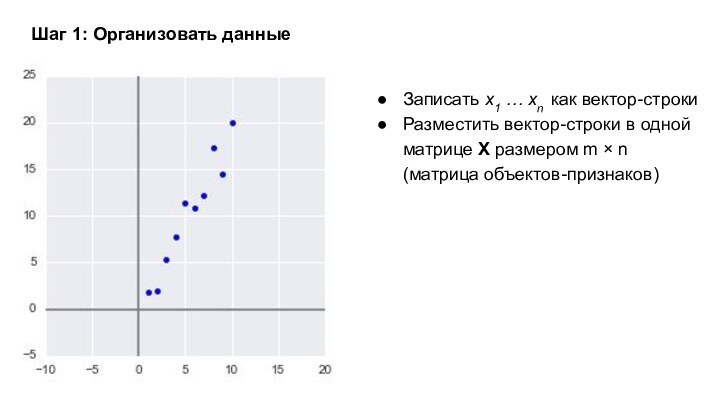

Записать x1 … xn как вектор-строки

Разместить вектор-строки в

одной матрице X размером m × n (матрица объектов-признаков)

Шаг

1: Организовать данные

Слайд 9

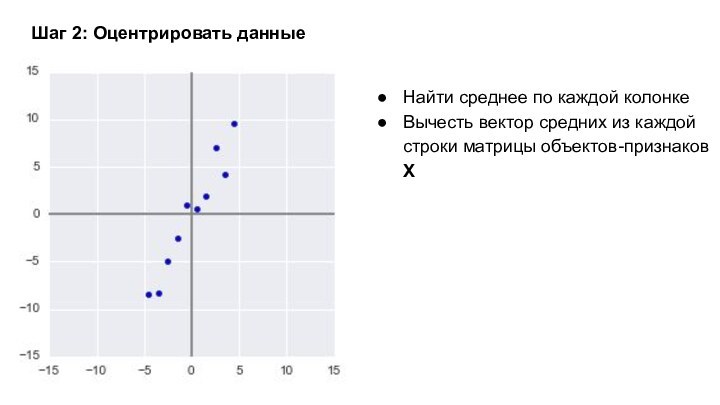

Шаг 2: Оцентрировать данные

Найти среднее по каждой колонке

Вычесть

вектор средних из каждой строки матрицы объектов-признаков Х

Слайд 10

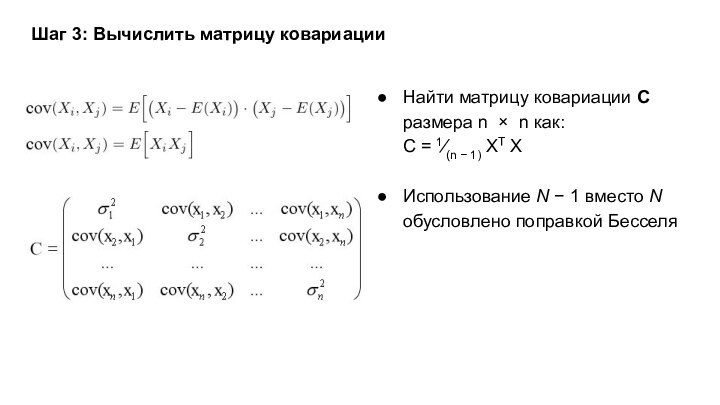

Шаг 3: Вычислить матрицу ковариации

Найти матрицу ковариации С

размера n × n как:

C = 1⁄(n − 1)

XT XИспользование N − 1 вместо N обусловлено поправкой Бесселя

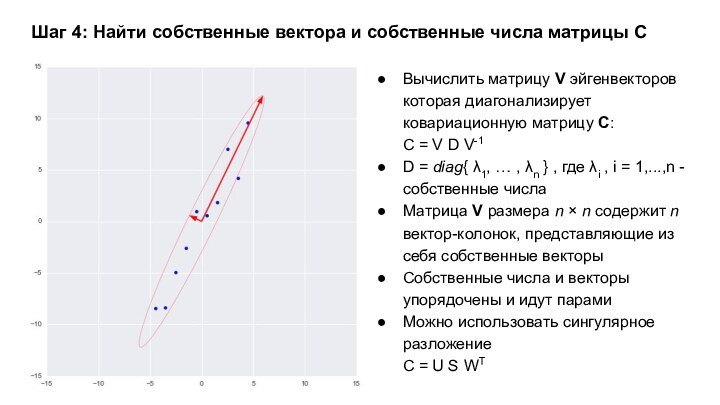

Слайд 11 Шаг 4: Найти собственные вектора и собственные числа

матрицы С

Вычислить матрицу V эйгенвекторов которая диагонализирует ковариационную матрицу

C:C = V D V-1

D = diag{ λ1, … , λn } , где λi , i = 1,...,n - собственные числа

Матрица V размера n × n содержит n вектор-колонок, представляющие из себя собственные векторы

Собственные числа и векторы упорядочены и идут парами

Можно использовать сингулярное разложение

C = U S WT

Слайд 12

Шаг 5: Проекция и реконструкция

В матрицу Vreduced записать

k вектор-колонок, соответствующих k наибольшим собственным числам.

Умножить Vreduced на

X чтобы получить проекции на главные компоненты:Z = Vreduced . X

Умножить VreducedT на проекции Z чтобы реконструировать данные:

X = VreducedT . Z

Слайд 17

Почему такой плохой результат?

Линейная комбинация объектов датасета не

является рукописной цифрой.

Значит объекты расположены в подпространстве, не являющемся

линейным.

Слайд 18

Нелинейные методы

Рассмотрим более простую модель и поставим задачу

нелинейного понижения размерности:

Задача — найти отображение объектов выборки в

пространство малой размерности, которое оптимизировало бы функционал качества.При этом мы не ограничены линейными отображениями.

Слайд 19

Гипотеза: малоразмерное представление сохраняет попарные расстояния между объектами.

- расстояние между xi и xj

- евклидово расстояние между малоразмерными представлениями Многомерное шкалирование