- Главная

- Разное

- Бизнес и предпринимательство

- Образование

- Развлечения

- Государство

- Спорт

- Графика

- Культурология

- Еда и кулинария

- Лингвистика

- Религиоведение

- Черчение

- Физкультура

- ИЗО

- Психология

- Социология

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Геометрия

- Детские презентации

- Информатика

- История

- Литература

- Маркетинг

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

Что такое findslide.org?

FindSlide.org - это сайт презентаций, докладов, шаблонов в формате PowerPoint.

Обратная связь

Email: Нажмите что бы посмотреть

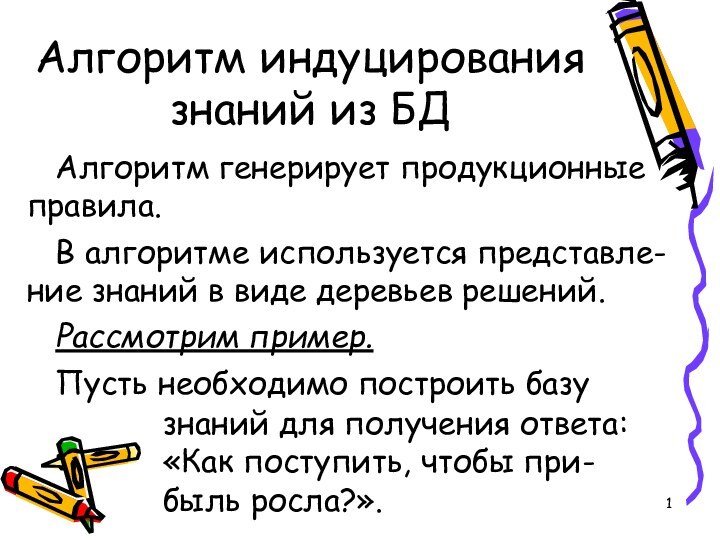

Презентация на тему Алгоритм индуцирования знаний из БД

Содержание

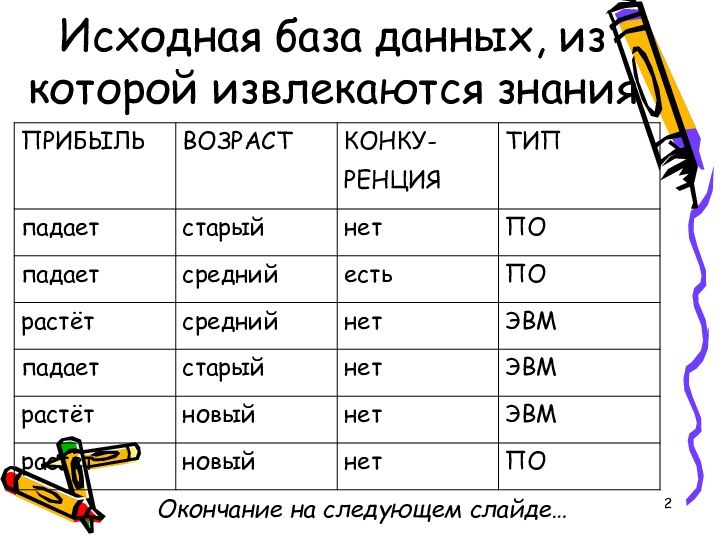

- 2. Исходная база данных, из которой извлекаются знанияОкончание на следующем слайде…

- 3. (окончание)

- 4. Искомый атрибут «Прибыль» будем называть атрибутом класса.Для

- 6. Из таблицы видно, что при значении атрибута

- 7. Получим другую таблицу:

- 8. Поскольку теперь для атрибута класса наше дерево

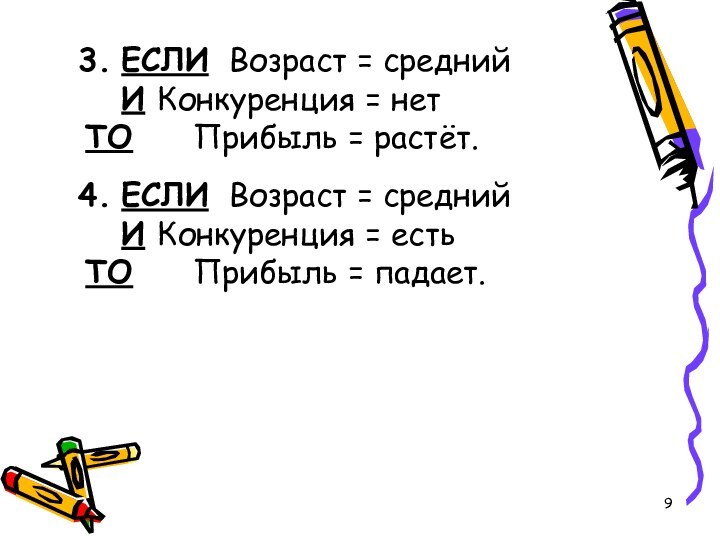

- 9. 3. ЕСЛИ Возраст = средний И Конкуренция = нет ТО Прибыль = растёт.4. ЕСЛИ Возраст = средний И Конкуренция = есть ТО Прибыль = падает.

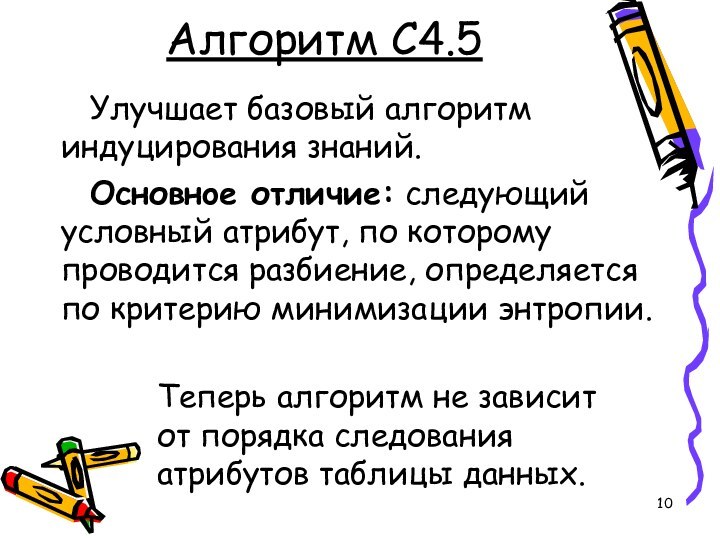

- 10. Алгоритм C4.5Улучшает базовый алгоритм индуцирования знаний.Основнoе отличие:

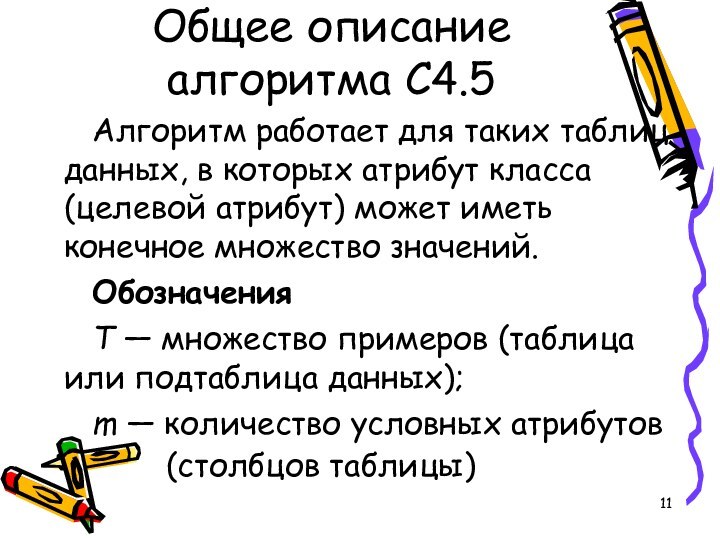

- 11. Общее описание алгоритма C4.5Алгоритм работает для таких

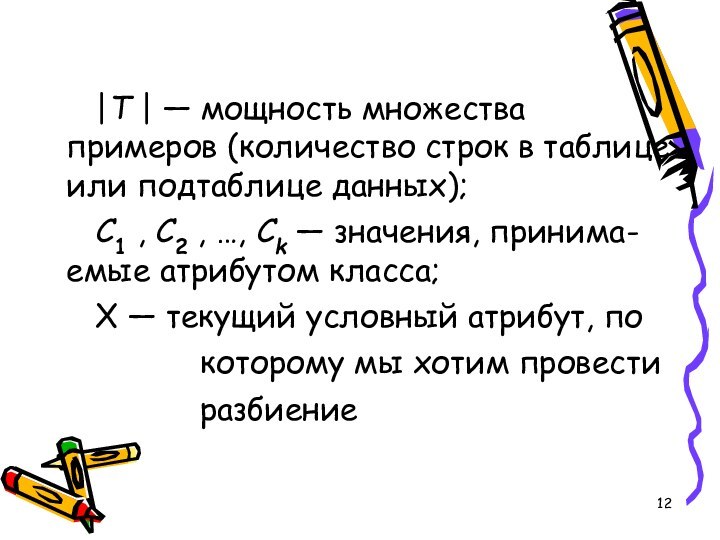

- 12. |T | — мощность множества примеров (количество

- 13. A1 , A2 , …, An — значения, принимаемые текущим условным атрибутом;

- 14. Выбор условного атрибута для разбиенияПусть рассматриваем условный

- 15. Тогда вероятность того, что случайно выбранная строка

- 16. Согласно теории информации, количество содержащейся в сообщении

- 17. Энтропия таблицы T, то есть среднее количество

- 18. Энтропия таблицы T после её разбиения по атрибуту X на n подтаблиц:

- 19. Критерий для выбора атрибута X – следующего атрибута для разбиения:

- 20. Шаги алгоритма C4.5Шаг 1. Для всех условных

- 21. Пример работы алгоритма C4.5В качестве примера возьмём

- 22. Расчёт критерия разбиения для атрибута «ВОЗРАСТ»Info(T1) =

- 23. Расчёт критерия разбиения для атрибута «КОНКУРЕЦИЯ»Info(T1) =

- 24. Скачать презентацию

- 25. Похожие презентации

Исходная база данных, из которой извлекаются знанияОкончание на следующем слайде…

Слайд 4

Искомый атрибут «Прибыль» будем называть атрибутом класса.

Для построения

дерева решений нужно взять один из атрибутов таб-лицы в

качестве основного (корневого) атрибута. Пусть это будет «Возраст».Преобразуем исходную таблицу к следующему виду (сортируем по графе Возраст):

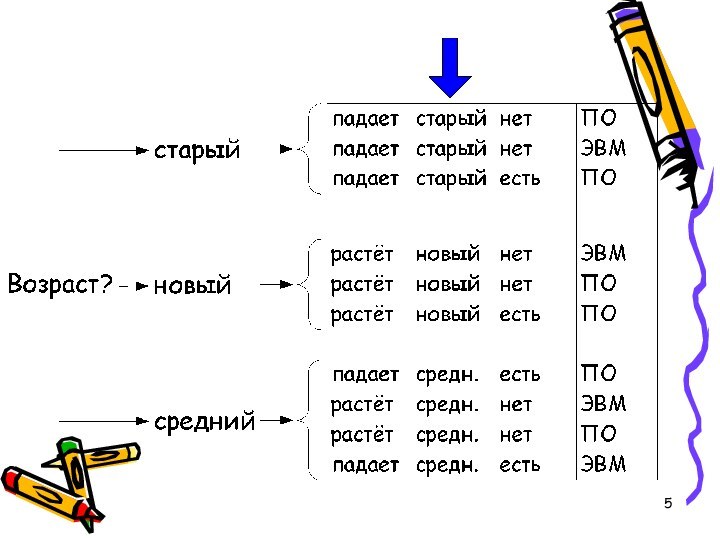

Слайд 6 Из таблицы видно, что при значении атрибута «Возраст»,

равном «новый», прибыль всегда растёт, а при значении «старый»

– падает.В случае же значения «средний» такого определённого вывода сделать нельзя.

Поэтому продолжим разбивку нижней подтаблицы по атрибуту Конкуренция».

Слайд 8 Поскольку теперь для атрибута класса наше дерево решений

выво-дит однозначный ответ, то дерево решений построено.

Порождаем правила:

1. ЕСЛИ Возраст =

новыйТО Прибыль = растёт.

2. ЕСЛИ Возраст = старый

ТО Прибыль = падает.

Слайд 9

3. ЕСЛИ Возраст = средний

И Конкуренция = нет

ТО Прибыль = растёт.

4. ЕСЛИ Возраст =

средний

И Конкуренция = есть

ТО Прибыль = падает.

Слайд 10

Алгоритм C4.5

Улучшает базовый алгоритм индуцирования знаний.

Основнoе отличие: следующий

условный атрибут, по которому проводится разбиение, определяется по критерию

минимизации энтропии.Теперь алгоритм не зависит от порядка следования атрибутов таблицы данных.

Слайд 11

Общее описание

алгоритма C4.5

Алгоритм работает для таких таблиц данных,

в которых атрибут класса (целевой атрибут) может иметь конечное

множество значений.Обозначения

T — множество примеров (таблица или подтаблица данных);

m — количество условных атрибутов

(столбцов таблицы)

Слайд 12

|T | — мощность множества примеров (количество строк

в таблице или подтаблице данных);

C1 , C2 , …,

Ck — значения, принима- емые атрибутом класса;X — текущий условный атрибут, по

которому мы хотим провести

разбиение

Слайд 14

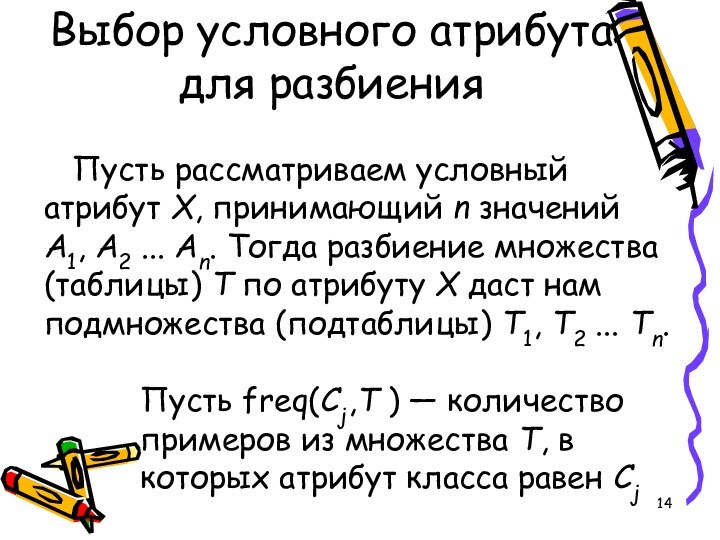

Выбор условного атрибута для разбиения

Пусть рассматриваем условный атрибут

X, принимающий n значений A1, A2 ... An. Тогда

разбиение множества (таблицы) T по атрибуту X даст нам подмножества (подтаблицы) T1, T2 ... Tn.Пусть freq(Cj,T ) — количество примеров из множества T, в которых атрибут класса равен Cj

Слайд 15 Тогда вероятность того, что случайно выбранная строка из

таблицы T будет принадлежать классу Cj, равна

Например, вероятность того,

что прибыль будет расти, составляет P = 5 / 10 = 0,5Слайд 16 Согласно теории информации, количество содержащейся в сообщении информации

зависит от её вероятности log2(1/P) = - log2(P).

В качестве

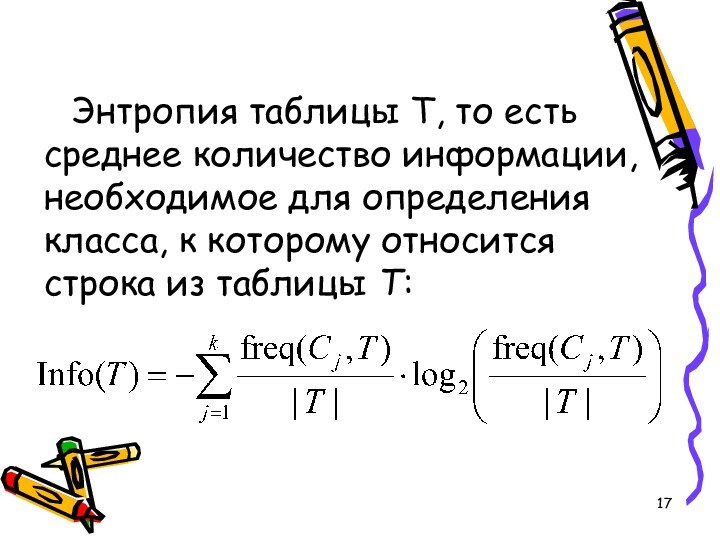

единицы энтропии принят бит, что соответствует логарифмам при основании 2.Слайд 17 Энтропия таблицы T, то есть среднее количество информации,

необходимое для определения класса, к которому относится строка из

таблицы T:

Слайд 20

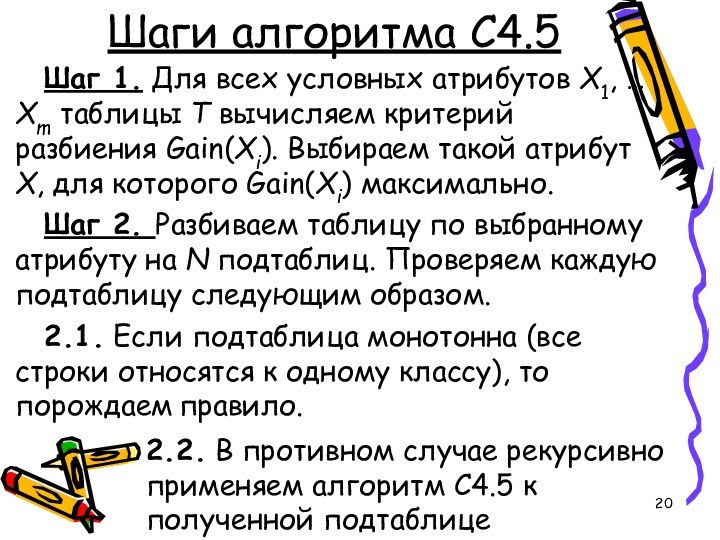

Шаги алгоритма C4.5

Шаг 1. Для всех условных атрибутов

X1, … Xm таблицы T вычисляем критерий разбиения Gain(Xi).

Выбираем такой атрибут X, для которого Gain(Xi) максимально.Шаг 2. Разбиваем таблицу по выбранному атрибуту на N подтаблиц. Проверяем каждую подтаблицу следующим образом.

2.1. Если подтаблица монотонна (все строки относятся к одному классу), то порождаем правило.

2.2. В противном случае рекурсивно применяем алгоритм C4.5 к полученной подтаблице

Слайд 21

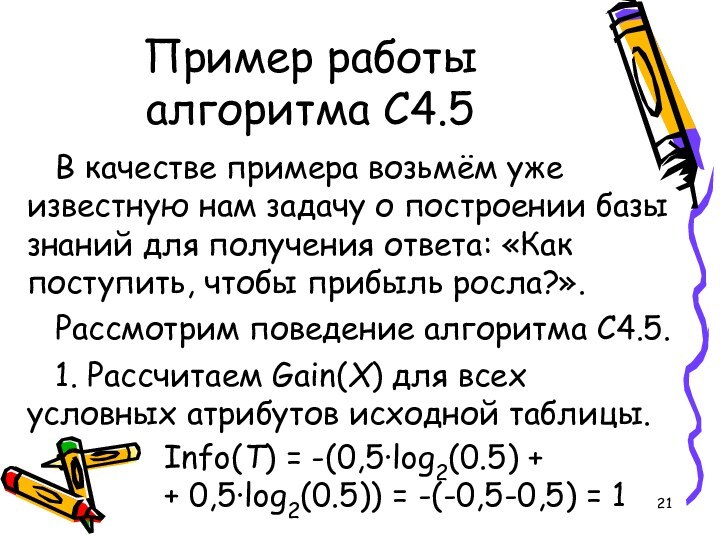

Пример работы алгоритма C4.5

В качестве примера возьмём уже

известную нам задачу о построении базы знаний для получения

ответа: «Как поступить, чтобы прибыль росла?».Рассмотрим поведение алгоритма C4.5.

1. Рассчитаем Gain(X) для всех условных атрибутов исходной таблицы.

Info(T) = -(0,5·log2(0.5) +

+ 0,5·log2(0.5)) = -(-0,5-0,5) = 1

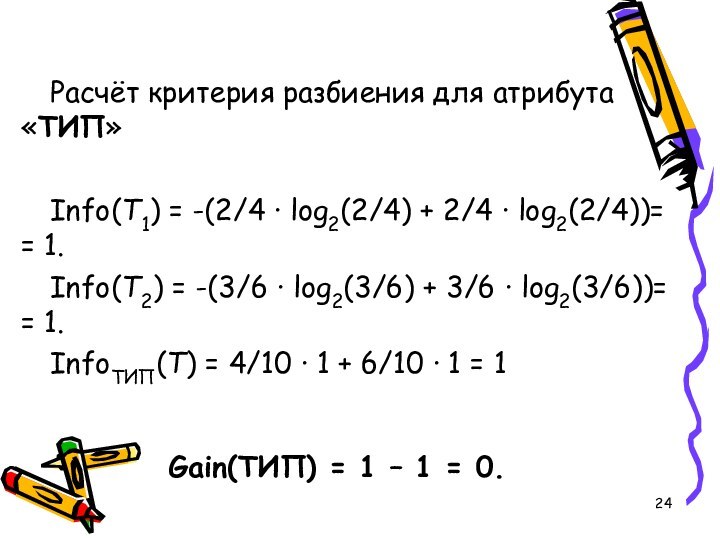

Слайд 22

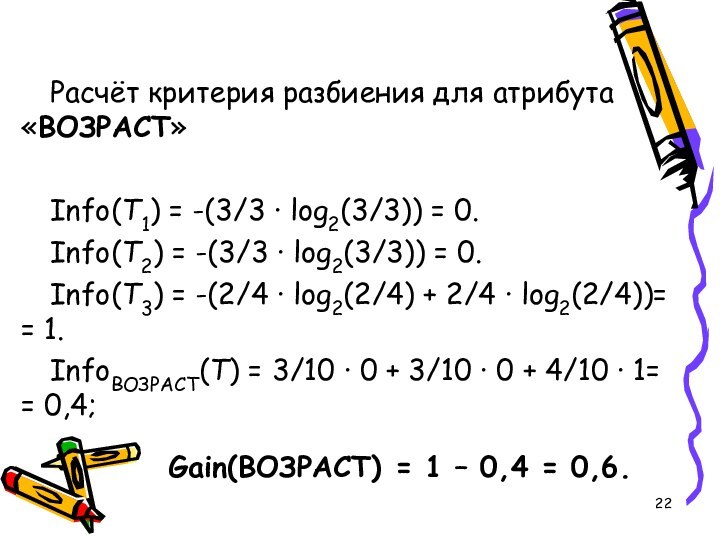

Расчёт критерия разбиения для атрибута «ВОЗРАСТ»

Info(T1) = -(3/3

· log2(3/3)) = 0.

Info(T2) = -(3/3 · log2(3/3)) =

0.Info(T3) = -(2/4 · log2(2/4) + 2/4 · log2(2/4))= = 1.

InfoВОЗРАСТ(T) = 3/10 · 0 + 3/10 · 0 + 4/10 · 1= = 0,4;

Gain(ВОЗРАСТ) = 1 – 0,4 = 0,6.

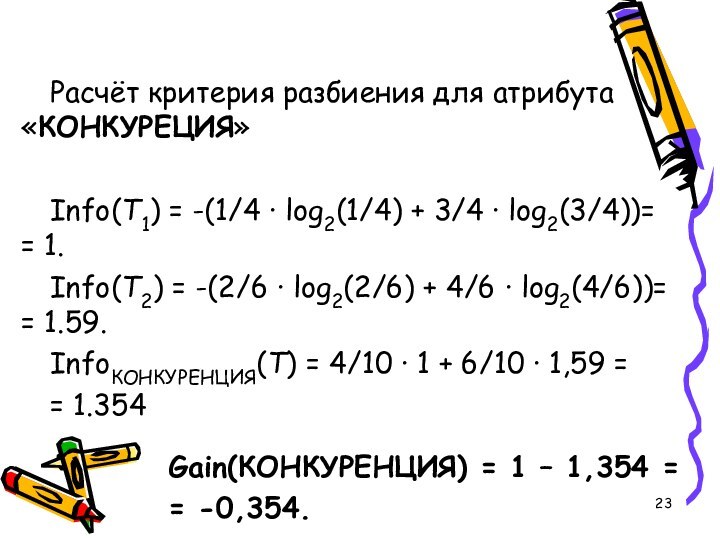

Слайд 23

Расчёт критерия разбиения для атрибута «КОНКУРЕЦИЯ»

Info(T1) = -(1/4

· log2(1/4) + 3/4 · log2(3/4))= = 1.

Info(T2) =

-(2/6 · log2(2/6) + 4/6 · log2(4/6))= = 1.59.InfoКОНКУРЕНЦИЯ(T) = 4/10 · 1 + 6/10 · 1,59 =

= 1.354

Gain(КОНКУРЕНЦИЯ) = 1 – 1,354 =

= -0,354.